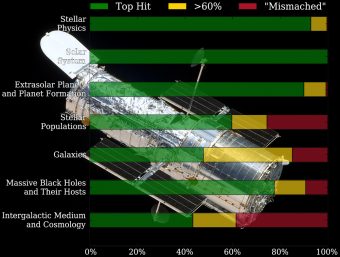

Confronto fra gli esiti della categorizzazione di Pacman e quella manuale sul corpus del 24esimo ciclo di proposte. In verde, le proposte classificate quasi allo stesso modo da entrambi. In giallo, quelle in parte sovrapponibili. In rosso le proposte categorizzate in modo diverso. Fonte: Louis-Gregory Strolger et al. 2017 AJ 153 181

Hubble, abbiamo un problema: il telescopio spaziale funziona così bene che tutti gli astronomi lo vogliono usare. Ma lui è uno soltanto. Risultato: le richieste di tempo osservativo non solo superano di gran lunga gli slot a disposizione, ma sono talmente numerose che anche solo dar loro una scorsa per decidere a quali esperti farle valutare sta diventando un compito improbo.

Diamo qualche cifra. In media arrivano 1100 proposte per ogni ciclo, di durata annuale, e per il prossimo è già stato infranto il record: l’ultimo giorno utile per l’invio, lo scorso venerdì 7 aprile, le domande hanno toccato quota 1200. È un po’ come se un albergo con una sola camera ricevesse, a ogni inizio d’anno, migliaia di richieste di prenotazioni per le 365 notti successive. Da una parte è un ottimo riscontro, segno che si tratta d’una struttura sempre più ambita. Dall’altra, non potendo cedere la “camera” a chi arriva prima o è disposto a pagare di più, ed essendo invece vincolato ad attenersi a criteri come la rilevanza scientifica e la possibilità di successo di ogni singola proposta, il team di Hubble è costretto a fare delle scelte. E la situazione pare destinata a peggiorare con il successore di Hubble, il James Webb Telescope, le cui ineguagliabili capacità attireranno ancora più scienziati.

Ecco dunque che un team di ricercatori dello Science Policies Group dello Space Telescope Science Institute (STScI), guidato da Louis-Gregory Strolger, sta provando a delegare, almeno in parte, la decisione a un algoritmo. Pacman, appunto: acronimo di Proposal Auto-Categorizer and Manager.

L’idea alla base del software, descritta in un articolo di Susanna Kohler su Aas Nova (il sito di notizie dell’American Astronomical Society), è quella dei classificatori bayesiani naive, usati per esempio in alcuni filtri anti-spam ad autoapprendimento. Anzitutto Pacman si “allena” sulle proposte degli anni precedenti, cercando d’individuare parole chiave ricorrenti da associare a settori specifici dell’astrofisica (fisica stellare, sistema solare, esopianeti, eccetera). Obiettivo: categorizzare in modo imparziale e autonomo ogni proposta, meglio di quanto non riescano a fare – sperano i ricercatori – gli stessi autori delle proposte. Sembra infatti, scrive Kohler, che il processo di autocategorizzazione, quello adottato fino a oggi, sia viziato da fraintendimenti e ambiguità: un po’ come se noi umani fossimo meno capaci di riconoscere al volo la pubblicità indesiderata rispetto – appunto – ai nostri filtri anti-spam.

Etichettate le proposte, Pacman passerebbe poi al vaglio gli abstract degli articoli, presenti nel database Ads (Astrophysical Data System), scritti negli ultimi dieci anni dai potenziali esperti ai quali affidare le valutazioni, basandosi anche in questo caso sulla ricorrenza di parole chiave e altri parametri quantitativi. Così da arrivare infine a individuare gli esperti più adatti per ogni proposta.

Potrebbe funzionare? I test preliminari mostrano che Pacman individua correttamente le categorie delle proposte nell’87 per cento dei casi, con buone possibilità d’arrivare al 95 per cento ampliando la base dati sulla quale ha condotto il percorso d’autoapprendimento. Quanto alla scelta dei revisori, stando all’algoritmo il 92 per cento di quelli scelti “a mano” nell’ultima valutazione (erano circa 150) sono stati etichettati come “appropriati”: vale a dire, Pacman era d’accordo con le decisioni prese dagli “smistatori umani”. Risultati promettenti, insomma. Anche se non ancora sufficienti per affidare, a scatola chiusa, all’algoritmo la scelta di chi dovrà decidere se una proposta merita o meno l’accesso a Hubble.

Per saperne di più:

- Leggi il preprint dell’articolo “The Proposal Auto-Categorizer and Manager for Time Allocation Review at Space Telescope Science Institute“, di Louis-Gregory Strolger, Sophia Porter, Jill Lagerstrom, Sarah Weissman, I. Neill Reid e Michael Garcia

- Leggi su Aas Nova l’articolo “PACMan to Help Sort Hubble Proposals“, di Susanna Kohler