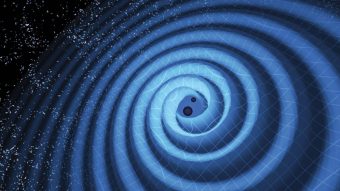

Crediti: Nasa

Una ricerca appena pubblicata su Physics Letters B, e firmata dai ricercatori del National Center for Supercomputing Applications (Ncsa) dell’Università dell’Illinois, apre le porte a una nuova stagione dell’astrofisica delle onde gravitazionali: quella in cui l’intelligenza artificiale ridurrà drasticamente i tempi di rilevamento e caratterizzazione dei dati raccolti.

La computer science vive la sua stagione d’oro e le reti neurali artificiali iniziano a fare davvero la differenza. Negli ultimi 15 anni i database si sono arricchiti: oggi su internet sono disponibili database composti da decine di milioni di immagini, la dieta preferita di questa macchine autoapprendenti. La potenza di calcolo, poi, è aumentata vertiginosamente grazie all’utilizzo delle Graphics Processing Unit (Gpu), inizialmente pensate per il mondo dei videogame ma che gli scienziati hanno imparato a usare per fare computazione scientifica ottenendo simulazioni su grande scala prima impensabili.

Ne abbiamo parlato qui su Media Inaf giusto prima delle feste, quando Nasa aveva annunciato la scoperta di un filotto di esopianeti, ottenuta grazie a un algoritmo di machine learning elaborato da Google per setacciare i dati della sonda spaziale Kepler.

Ed è combinando una rete neurale artificiale potenziata dalle Gpu di ultima generazione, fornite da Nvidia (Tesla P100 e DGX-1), con simulazioni di eventi astrofisici complessi, come la fusione di due buchi neri e i dati messi a disposizione del Ligo Open Science Center, che i ricercatori dell’Illinois sono riusciti a costruire Deep Filtering. Il Gravity Group Ncsa guidato da Daniel George e Eliu Huerta ha di fatto costruito una macchina in grado di sostituire i “costosi” algoritmi di rilevamento delle onde gravitazionali: Deep Filtering è altrettanto sensibile ai dati, commette meno errori, è più efficiente dal punto di vista computazionale e più resiliente ai rumori e alle anomalie nei dati raccolti.

Lavorando sui dati messi a disposizione dal Ligo Open Science Center, il gruppo di ricerca di George e Huerta ha scoperto non solo che Deep Filtering permetterebbe agli astrofisici di fare più cose in minor tempo, ma che l’utilizzo del machine learning può condurre dritti dritti a una nuova fisica, perché in grado di rilevare classi di sorgenti di onde gravitazionali che potrebbero essere passate inosservate (e che potrebbero passare inosservate in futuro) agli algoritmi di rilevamento attualmente impiegati.

Il Gravity Group Ncsa sta già lavorando per estendere Deep Filtering all’identificazione in tempo reale di controparti elettromagnetiche in eventi di onde gravitazionali nei dati che raccoglierà il Large Synoptic Survey Telescope.

George e Huerta hanno collaborato con i ricercatori di Nvidia e Wolfram Research per creare una demo e visualizzare l’architettura di Deep Filtering per ottenere informazioni sulla sua attività neuronale durante il rilevamento e la caratterizzazione di eventi di onde gravitazionali reali. Un lavoro che si è aggiudicato il primo posto al concorso Acm Student Research della Science Computing Conference edizione 2017.

Per saperne di più:

- Leggi l’articolo “Deep Learning for Real-time Gravitational Wave Detection and Parameter Estimation: Results with Advanced LIGO Data“, di Daniel George ed Eliu A. Huerta, pubblicato su Physics Letters B

Guarda il servizio video su MediaInaf Tv: