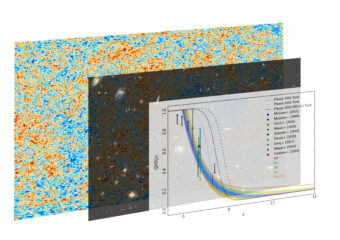

Storia della reionizzazione in funzione del redshift come ricostruita dall’unione dei dati della CMB (sfondo) e astrofisici (Hubble Frontier Field immagine mediana) per i vari casi considerati. Crediti: Galaxy image: Esa/Hubble & Nasa Acknowledgement: Judy Schmidt (Geckzilla), Cmb: Esa/Planck Collaboration

Nel primo miliardo di anni rispetto a quella che viene considerata l’origine dell’universo, ombra e luce si sono susseguite fino a quella che prende il nome di epoca della reionizzazione: il periodo in cui il gas primordiale, di cui era pervaso l’universo nelle prime fasi della sua evoluzione, passa dallo stato neutro a quello ionizzato. La storia di quest’epoca non è ancora chiara, così come non è ancora ben definito il periodo esatto in cui si svolse. Su questo tema, tanto difficile quanto affascinante, Media Inaf ha intervistato Daniela Paoletti, ricercatrice dell’Inaf Oas di Bologna, che si occupa di reionizzazione da molti anni, prima nell’ambito della collaborazione Planck e ora di quella Litebird. Recentemente Daniela ha pubblicato uno studio, svolto con i colleghi Dhiraj Kumar Hazra e Fabio Finelli, che vede la partecipazione anche del premio Nobel per la fisica nel 2006 George Smoot, ed è soprattutto su questo lavoro che le abbiamo chiesto un approfondimento.

Come è nata l’idea alla base del lavoro presentato in questa pubblicazione?

«Il lavoro è nato da una collaborazione che abbiamo ormai da lungo tempo con Dhiraj Kumar Hazra, ora professore a Imsc Chennai (India) e precedentemente Infn e AstroFit fellow a Bologna. Insieme a Fabio Finelli, ho iniziato a collaborare con Dhiraj quando ancora era al Paris Center for Cosmological Physics (Pccp), come post-doc di George Smoot, sulla reionizzazione. In generale, ci siamo occupati dello studio della reionizzazione e di tutte le degenerazioni che presenta con i modelli alternativi al modello cosmologico standard. Insieme, abbiamo scritto diversi articoli in merito, utilizzando quelli che sono i metodi più classici per studiare la reionizzazione, in pratica fittare quanto l’universo è ionizzato nel tempo. Poi, nel 2018, vedendo i nuovi risultati di Planck con uno spessore ottico così più basso, che indicava una reionizzazione tra redshift 6 e 10, è iniziato a diventare molto interessante il connubio con i dati astrofisici, ossia per esempio i dati dell’Hubble Frontier Field – che è andato a guardare le galassie tra redshift 5 e 11 – e i dati dei quasar, direttamente sulla Lyman alpha, che misurano quanto l’universo è ionizzato a redshift tra 5 e 8. Quindi abbiamo tre dataset che stanno tutti puntando in quella zona di redshift. La nostra idea originale è stata quella di cercare un modo per metterli insieme».

Qual è l’originalità del lavoro?

«Con i metodi classici, fittando la frazione di reionizzazione (quanto l’universo è reionizzato) non si riesce a incorporare i dati astrofisici, soprattutto i dati di Hubble, che sono dati sulla luminosità ultravioletta delle galassie, la sorgente della ionizzazione. È qui che è subentrata l’idea originale: non partiamo più studiando quella che è la curva di ionizzazione bensì andiamo a studiare l’equazione della reionizzazione variando anche tutta la cosmologia allo stesso tempo. Quindi, invece di studiare il risultato, studiamo le sorgenti. Quello che facciamo è andare a utilizzare l’equazione per quello che si chiama volume filling factor della ionizzazione, in cui abbiamo da un lato la densità di luminosità ultravioletta – che è la sorgente che ionizza – dall’altro il suo avversario: il tempo di ricombinazione. Ci siamo chiesti: cosa succede nel momento in cui andiamo a lasciare libere queste due quantità, e le facciamo guidare dai dati? I dati ci dicono come sono, noi risolviamo la nostra equazione per la ionizzazione nella quale le sorgenti sono vincolate dai dati e dopo andiamo a vedere come si è svolta la storia della reionizzazione. Il cambio è stato proprio questo: passare dallo studiare direttamente la frazione di reionizzazione – che è quello che abbiamo fatto in altri articoli con George e Dhiraj – al far sì che i dati guidino i vincoli sulle sorgenti, insieme ai parametri cosmologici».

Questo cosa comporta, ai fini pratici?

«In questa maniera è possibile mettere insieme i dati sulla luminosità ultravioletta, sulla Lyman alpha, e i dati del fondo cosmico a microonde (Cmb, acronimo di Cosmic Microwave Background). Questi ultimi sono fondamentali, perché è vero che la loro potenza più grossa è ai redshift alti – ovviamente perché il Cmb è un osservabile cosmologico – però così possiamo variare tutta la cosmologia insieme alla storia della reionizzazione, perché dalla storia della reionizzazione dipendono tutti i vincoli ai parametri cosmologici che abbiamo nel modello cosmologico standard. Perché, per esempio, lo spessore ottico è degenere con l’ampiezza delle fluttuazioni primordiali, con il tilt delle fluttuazioni primordiali. Quindi è fondamentale covariare tutto insieme».

Cosa vuole dire che i parametri sono degeneri?

«Quando diversi insiemi di parametri portano allo stesso risultato, si dice che sono degeneri. Lo stesso universo può essere creato da una coppia di parametri con valori A e B, ma anche da una diversa coppia di valori C e D degli stessi parametri. Semplicemente perché i parametri sono correlati tra di loro».

Qual è la potenza dell’intuizione che avete avuto e cosa vi ha permesso di ottenere?

«È molto importante, quando si studia la reionizzazione (come avevamo mostrato nei lavori precedenti) andare a testare tutto l’insieme dei parametri cosmologici e per questo il Cmb è molto potente, perché ci fornisce il grip sui parametri che altrimenti non avrebbero alcun tipo di vincolo. In questo modo si mettono insieme tre osservabili – l’estremamente lontano nel tempo e gli osservabili più vicini, come le galassie e i quasar – e la cosa bella è che c’è un accordo spettacolare. Quando mettiamo insieme tutti e tre i set di dati, c’è una convergenza a uno spessore ottico – che è il parametro che si usa per rappresentare la reionizzazione – che è perfettamente in accordo con Planck. Questa cosa è molto bella perché ti mostra la compatibilità dei diversi dati e nel contempo, mettendo insieme il Cmb e i dati astrofisici, si rompono tutte le degenerazioni, quindi la storia della reionizzazione viene vincolata indipendentemente dal modello cosmologico, proprio perché i dati astrofisici riescono a darti un vincolo a sé stante».

Cosa avete scoperto sulla storia della reionizzazione?

«Abbiamo esplorato una serie di gradi di complessità: invece di andare ad analizzare un intervallo da 5.5 a 30 (che è quello che viene fatto nel modello minimale), possiamo suddividere l’intervallo in tanti intervalli di redshift, e quindi andare a vedere se ci sono più step della reionizzazione: ad esempio, se c’è stato un primo burst e poi tutto si è appianato, e poi un altro burst. Siamo arrivati fino a tre intervalli e quello che vediamo è che in realtà sembra che l’universo preferisca la reionizzazione più semplice di tutte: una semplice monotona, non così ripida come viene usata nella cosmologia tradizionale (nel lambda Cdm classico viene usata una tangente iperbolica, che praticamente è un gradino), un po’ più dolce come pendenza però senza burst multipli… liscia, una singola salita. Ecco, questa sembra essere preferita dai dati. In realtà questo si era già visto con i modelli precedenti, che studiano direttamente la frazione di reionizzazione. Questa ricostruzione non parametrica, non vincolata a uno specifico modello, sembra confermare questa semplicità della storia della reionizzazione».

Come mai c’è voluto tanto a pubblicare il lavoro?

«La prima versione è del 2018, nella quale avevamo usato i vecchi dati di Planck, quelli della release del 2015. Durante la fase di referaggio è uscita la nuova release dei dati di Planck e allora ci siamo detti che avremmo potuto prenderci un pochino più tempo per aggiornare tutti i risultati con i dati di Planck 2018. L’abbiamo quindi ri-sottomesso a distanza di diversi mesi, semplicemente perché abbiamo rifatto l’analisi con i dati nuovi. Cosa che tra l’altro si è rivelata eccezionale, perché i dati nuovi di Planck sono meravigliosi. Quindi, di fatto, aspettare ne è valsa la pena perché questo aggiornamento ha aggiunto tanto all’analisi».

Perché i dati di Planck 2018 sono migliori di quelli del 2015. Cosa è cambiato?

«Nei dati di Planck rilasciati nel 2015 l’analisi della polarizzazione alle grandi scale angolari era basata sullo strumento a bassa frequenza, in particolar modo sul canale a 70 GHz (pulito con il 30 GHz e il 353 GHz). Invece nel 2018 si è passati a una polarizzazione a grande scala basata sullo strumento ad alta frequenza e in particolar modo su quello che si chiama spettro incrociato (cross) tra i due canali a 100 e 143 GHz. Questo spettro, per sua natura, ha un errore minore. Lo strumento ad alta frequenza aveva una sensibilità leggermente migliore e questo ha permesso di avere dei dati con un errore più basso, e quindi di migliorare le stime. In conclusione, l’incertezza sulla spessore ottico ottenuto con i dati del 2018 è minore, quindi migliore. E il valore si abbassa, rispetto a quelli che sono i dati del 2015. Detto ciò, rimane sempre valida anche l’analisi con lo strumento a bassa frequenza che è stata fatta e rilasciata nel 2018, con un ottimo errore. Da questa analisi lo spessore ottico, seppur compatibile con la nuova stima, è leggermente più alto».

Com’è lavorare fianco a fianco con un premio Nobel?

«Ho conosciuto George a un mio seminario alla Pccp, nel quale mi avevano invitata a parlare dei campi magnetici primordiali e del relativo paper Planck del 2015. Ero lì, tranquilla e pronta a fare il mio seminario ai soliti post doc e ricercatori del posto, quando Ken Ganga – che mi stava presentando i suoi post doc – sento che dice: “Ah! Abbiamo anche un premio Nobel tra noi!”. Sono sbiancata. In quell’occasione, al termine del mio seminario, abbiamo interagito su alcune idee. È una persona molto cordiale ed estremamente precisa. È una biblioteca vivente: qualsiasi articolo sia stato pubblicato, credo che lui l’abbia letto. Ha tantissime idee sui dati: una vera sorgente di ispirazione! Ovviamente interagisce principalmente con Dhiraj, ma quando i paper sono pronti, la sua rilettura è fondamentale: a lui non sfugge niente. Qualsiasi dubbio che può nascere da ciò che abbiamo scritto, lui lo tira fuori».

E adesso cosa farete? Quali sviluppi prevedete?

«Adesso c’è l’evoluzione di questo studio, nel quale abbiamo fatto alcune approssimazioni, visto che era la prima volta che si tentava di fare una cosa del genere e volevamo vedere se sarebbe riuscita. Abbiamo testato le approssimazioni solo per casi specifici nei quali alcuni parametri avevano valori fissati dai dati. Adesso vogliamo iniziare a complicare il modello lasciando liberi anche questi parametri, per vedere come i vari dati possono spostare i vincoli sui parametri stessi. Questo in funzione anche del futuro, perché possiamo dire che Planck è lo stato dell’arte per la polarizzazione del Cmb da qui fino alla fine della decade alle grandi scale angolari, ma se tutto va bene ci sarà Litebird – il successore di Planck. Quindi è interessante fare delle previsioni sia per quello, sia per i dati astrofisici, che miglioreranno notevolmente grazie a strumenti quali Jwst, che verrà lanciato a breve. Anche Theseus si pone l’obiettivo di studiare la reionizzaione. Ci stiamo preparando la strada per vedere dove potremmo arrivare, nell’arco di dieci o quindici anni, con questo tipo di studi, grazie ai futuri esperimenti. Per farlo, dobbiamo aumentare la complessità della nostra analisi».

Per saperne di più:

- Leggi su Physical Review Letters l’articolo “Joining Bits and Pieces of Reionization History” di Dhiraj Kumar Hazra, Daniela Paoletti, Fabio Finelli e George F. Smoot