L’universo si è espanso enormemente nell’ultimo mese, almeno nel mondo delle simulazioni. All’inizio di novembre, i ricercatori dell’Argonne National Laboratory del Doe, il Dipartimento dell’energia statunitense, hanno utilizzato uno dei supercomputer più performanti del pianeta per eseguire la più grande simulazione idrodinamica dell’universo mai realizzata.

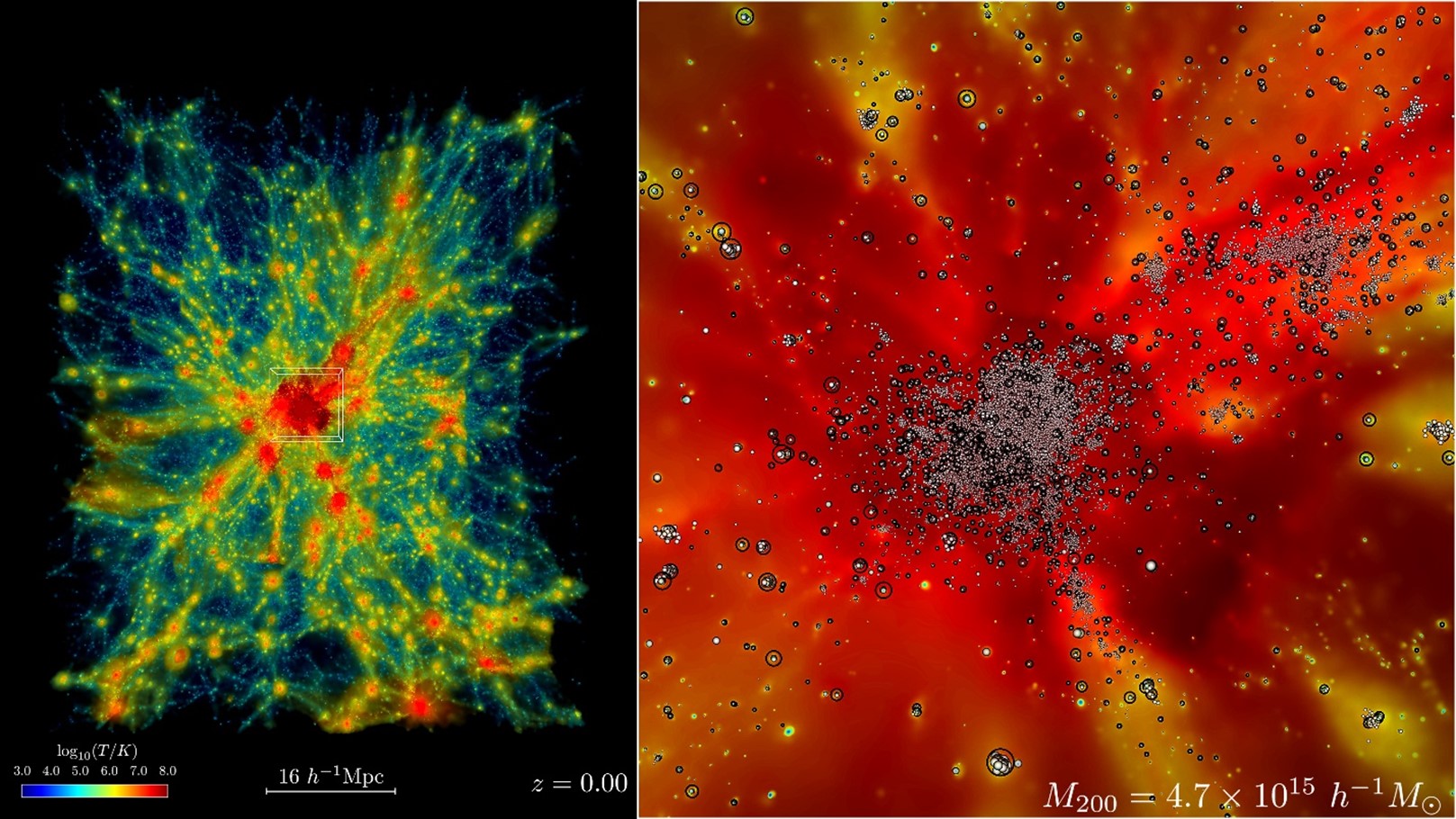

Un piccolo campione delle simulazioni di Frontier mostra l’evoluzione dell’universo in espansione in una regione contenente un enorme ammasso di galassie da miliardi di anni fa a oggi (a sinistra). Le aree rosse mostrano i gas più caldi, con temperature che raggiungono i 100 milioni di kelvin o più. Zoomando (a destra), le particelle traccianti delle stelle ripercorrono la formazione delle galassie e il loro movimento nel tempo. Crediti: Laboratorio nazionale di Argonne, Dipartimento dell’energia degli Stati Uniti

A renderlo possibile, il supercomputer Frontier dell’Oak Ridge National Laboratory, che ha ora stabilito un nuovo punto di riferimento per le simulazioni di idrodinamica cosmologica. La parola chiave per comprendere questo primato, è proprio “idrodinamica”: un aggettivo che distingue questa classe di simulazioni da quelle che utilizzano solo la forza di gravità per determinare l’evoluzione degli aloni di materia oscura nel tempo. Facciamo allora un passo indietro, per capire bene di che cosa si sta parlando.

La struttura su larga scala dell’universo, ovvero la rete cosmica sulla quale si formano tutte le strutture visibili e osservabili, è fatta di aloni di materia oscura più o meno densi all’interno dei quali collassa il gas barionico (la materia normale, visibile) che dà vita a stelle, galassie, gruppi e ammassi di galassie. Se avete mai visto l’immagine di qualche simulazione (oppure potete guardare il pannello di sinistra dell’immagine qui sopra), somiglia un po’ a un’enorme rete neurale. Gli aloni più grandi ospitano le strutture cosmiche più grandi, come gli ammassi di galassie, mentre i filamenti raggruppano sempre meno oggetti fino alle singole galassie. Ora, quando si vuole simulare l’evoluzione di queste strutture cosmiche nel tempo, lo si può fare in due modi: guardando solamente come evolvono gli aloni di materia oscura che ospitano le strutture, e quindi inserendo come ingrediente la sola forza di gravità (poiché, per quanto ne sappiamo, la materia oscura interagisce solo gravitazionalmente), oppure tentando di riprodurre contemporaneamente il comportamento della materia oscura e del gas di barioni che la popola. In questo caso, la simulazione conterrà molti più ingredienti e molte più leggi fisiche che agiscono ed evolvono di concerto. Per questo le simulazioni di idrodinamica cosmologica sono molto più costose dal punto di vista computazionale e molto più difficili da realizzare rispetto alle simulazioni di un universo in espansione che coinvolgono solo gli effetti della gravità.

«Se vogliamo sapere cosa sta facendo l’universo, dobbiamo simulare entrambe le cose: la gravità e tutta l’altra fisica, compreso il gas caldo e la formazione di stelle, buchi neri e galassie», dice Salman Habib, direttore della divisione di scienze computazionali di Argonne e responsabile del progetto che ha permesso di realizzare la simulazione. «Per esempio, se dovessimo simulare un’ampia porzione di universo rilevata da uno dei grandi telescopi come il prossimo Osservatorio Vera Rubin, in Cile, si tratta di esaminare enormi porzioni di tempo cosmico: miliardi di anni di espansione. Fino a poco tempo fa, non potevamo nemmeno immaginare di fare una simulazione di queste dimensioni, se non con l’approssimazione della sola gravità».

Le dimensioni della simulazione, come dice appunto Habib, corrispondono alle porzioni di cielo osservabili con i più grandi telescopi oggi in costruzione, un’impresa che finora non era stata possibile a questa scala. Il codice del supercomputer utilizzato per la simulazione si chiama Hacc, acronimo di Hardware/Hybrid Accelerated Cosmology Code. È stato sviluppato circa 15 anni fa per le macchine petascale, per poi essere notevolmente potenziato nell’ambito di ExaSky, un progetto speciale guidato da Habib nell’ambito dell’Exascale Computing Project, un’iniziativa del Dipartimento dell’energia statunitense da 1,8 miliardi di dollari che si è svolta dal 2016 al 2024.

«Si tratta del primo caso di una simulazione che sfrutta le risorse computazionali di una macchina, Frontier, della cosiddetta classe exascale, in grado di compiere oltre un miliardo di miliardi di operazioni semplici al secondo. Ne esistono solo tre al mondo al momento, tutte negli Usa, e Frontier è al secondo posto assoluto per capacità», commenta Andrea Possenti, ricercatore dell’Inaf di Cagliari e responsabile dell’Unità di supercalcolo dell’Istituto nazionale di astrofisica. «Non sono ancora noti i dettagli della simulazione, ma essa stabilisce certamente un nuovo parametro di riferimento per tutti i lavori nel settore, ad alcuni anni di distanza dalla produzione di simulazioni cosmologiche, come la Magneticum o la Illustris, che hanno avuto innumerevoli applicazioni in tempi recenti».

E se finora abbiamo parlato solamente di dimensioni, ecco, non contano solo quelle. La simulazione, infatti, non solo copre scale cosmiche che consentono un confronto diretto con le moderne osservazioni, ma lo fa raggiungendo un realismo fisico senza precedenti, garantito appunto dall’inclusione dei barioni e di tutta la fisica dinamica degli atomi e del gas. E l’Europa, quando riuscirà a essere competitiva?

«Non stiamo certo a guardare», dice Possenti. «Da un lato, all’interno del Centro di eccellenza europeo CoE-Space (dove i ricercatori di Inaf ricoprono ruoli di primo piano), si stanno sviluppando codici di simulazione molto più complessi, e quindi ancor più realistici, di quelli utilizzati per la simulazione su Frontier, comprendendo ad esempio gli effetti dei buchi neri e della formazione stellare sull’evoluzione delle mega strutture cosmiche. Dall’altro, ovvero dal punto di vista dell’hardware, c’è già la macchina pre-exascale Leonardo (la nona macchina più potente al mondo oggi) presso il Tecnopolo di Bologna, a cui anche i ricercatori di Inaf hanno accesso tramite appositi accordi con il Cineca. E poi Jupiter, la prima macchina europea exascale, localizzata in Germania, è in gestazione e andrà in produzione fra pochi mesi».