L’era delle indagini astronomiche su larga scala rappresenta una sfida che richiede approcci innovativi per fare fronte a una mole sempre più voluminosa di dati da analizzare, e una direzione promettente per affrontare questa sfida è certamente offerta dall’intelligenza artificiale.

Uno studio ora in uscita su Astronomy & Astrophysics propone di integrare tecniche sofisticate di machine learning – già applicate con successo in altri campi scientifici – e di adattarle all’analisi degli spettri di galassie per predire quantità fondamentali come redshift, massa stellare e tasso di formazione stellare delle galassie. Il modello si chiama M-Topnet (Multi-task network outputting probabilities) ed è basato su una rete neurale artificiale piuttosto articolata. M-Topnet non si limita a classificare o stimare un singolo parametro ma, grazie all’apprendimento multi-task, analizza contemporaneamente diverse proprietà fisiche delle galassie. Inoltre, è capace di associare alle stime di queste grandezze anche una distribuzione di probabilità – e quindi un’incertezza – permettendo così di valutare l’affidabilità di ciascun risultato. Lo strumento è stato progettato per essere capace di elaborare gli spettri prodotti dallo spettrografo di ultima generazione Moons (Multi Object Optical and Near-infrared Spectrograph), che verrà installato nei prossimi mesi al Very Large Telescope dell’Eso, in Cile.

Ma cosa c’è di veramente nuovo in questo strumento di intelligenza artificiale? Lo abbiamo chiesto a Michele Ginolfi dell’Università di Firenze, alla guida dello studio.

In cosa si distingue M-Topnet dai metodi standard di machine learning?

«I metodi standard per analizzare gli spettri di galassie si basano principalmente sul confronto con modelli teorici o template preesistenti, cercando il miglior match. Questi metodi funzionano, ma hanno dei limiti: sono lenti, richiedono una grandissima quantità di informazioni e tendono a perdere precisione con dati di bassa qualità o quando le caratteristiche spettrali non sono ben definite. Il nostro metodo, invece, sfrutta una rete neurale artificiale molto flessibile che, una volta addestrata, è in grado di imparare direttamente dai dati come collegare lo spettro osservato alle proprietà fisiche della galassia. Ciò che lo rende speciale è che, per il redshift, non fornisce un singolo valore, ma una distribuzione di probabilità: una sorta di “mappa” che mostra quanto siamo sicuri delle diverse possibili soluzioni».

Cosa si intende per apprendimento multi-task?

«Si tratta di un approccio in cui un modello di intelligenza artificiale viene addestrato per svolgere più compiti contemporaneamente, anziché uno solo. Questo approccio ha diversi vantaggi: i compiti sono connessi tra loro, quindi le informazioni che il modello impara da uno possono aiutare a migliorare le predizioni sugli altri. Compiti principali come la stima del redshift sono affiancati da funzioni ausiliarie, come l’identificazione delle linee spettrali. Questi compiti secondari aiutano il modello a costruire una rappresentazione interna più completa dei dati, che non solo migliora le prestazioni nei compiti principali, ma rende il modello più robusto e capace di generalizzare meglio. Pensiamo alla cucina: se vuoi diventare un maestro nel preparare primi piatti spettacolari, probabilmente non andresti a una scuola che insegna solo primi piatti. Preferiresti piuttosto un corso di cucina completa su come preparare primi, secondi, dolci e altro, perché in questo modo impareresti in modo più versatile e generale tecniche che sono comuni ai diversi tipi di piatti, come dosare il sale, gestire i tempi di cottura o abbinare i sapori».

Definite il vostro modello diverso da una delle solite “scatole nere”. Cosa significa?

«Le reti neurali artificiali spesso vengono definite “black box” perché è difficile capire cosa avviene al loro interno: sappiamo cosa entra e cosa esce, ma non sempre riusciamo a interpretare come si arriva a certe conclusioni. Nel nostro caso, però, non è proprio così. Analizzando lo spazio latente – cioè le rappresentazioni interne che la rete costruisce per interpretare i dati – siamo riusciti a individuare una struttura ben precisa, che riflette alcune proprietà fisiche delle galassie, incluse alcune mai mostrate al modello durante l’addestramento. Un esempio? La rete distingue spontaneamente tra galassie passive ed attive, una caratteristica che non era parte del processo di apprendimento. È come se la rete avesse imparato da sola a identificare nuovi pattern e simmetrie nei dati, suggerendo informazioni emergenti. Questo non solo rende la pipeline più interpretabile, ma apre anche la strada a nuove scoperte».

Mi scusi, cosa è una pipeline?

«Per pipeline intendiamo una sequenza organizzata di passaggi, o fasi, che i dati attraversano per essere analizzati e trasformati. Nel nostro caso, la pipeline parte dallo spettro della galassia e, tramite vari passaggi di elaborazione, stima alcune proprietà fisiche della galassia stessa. È come una “catena di montaggio” del dato: ogni passaggio è progettato per aggiungere informazioni o raffinare il risultato finale».

It’s my pleasure to introduce the M-TOPnet (Multi-Task network Outputting Probabilities) pipeline to you

“Measuring redshift and galaxy properties via a multi-task neural net with probabilistic outputs: an application to simulated MOONS spectra”https://t.co/AlgCLXhAyu pic.twitter.com/cE1Gay6uTm

— Michele Ginolfi (@micginolfi) October 31, 2024

In cosa la vostra pipeline è diversa, per esempio, da ChatGpt, che ci risulta già più familiare?

«ChatGpt è un modello generativo multi-modale, progettato per comprendere e generare testo e immagini appartenenti a un dominio molto ampio e generale. Il nostro modello, invece, è specializzato nell’affrontare un compito più mirato in un dominio più specifico: misurare le proprietà fisiche delle galassie a partire dai loro spettri. A differenza di ChatGpt, non si limita a produrre una risposta “diretta”, ma ci fa sapere quando non è convinto di un risultato. È interessante notare che modelli simili a ChatGpt stanno iniziando a emergere anche in astronomia, e saranno capaci di trattare dati complessi come testo, immagini e spettri, integrandoli per nuove analisi. Ne vedremo delle belle!».

Come fate a capire se le risposte fornite dal vostro modello sono affidabili?

«Questo è proprio uno degli aspetti più innovativi della nostra pipeline. Grazie a un approccio probabilistico integrato, il nostro modello tiene conto sia delle incertezze nei dati (aleatorie) sia di quelle legate alla rete neurale stessa (epistemiche). Così, possiamo non solo fare previsioni accurate, ma anche capire quanto possiamo fidarci di esse. L’aspetto dell’incertezza associata alla misura è particolarmente cruciale per dati complessi come gli spettri di galassie. Ad esempio, abbiamo osservato che quando la predizione è sbagliata – magari perché il segnale è troppo debole e nascosto nel rumore, oppure perché lo spettro non presenta righe di emissione – il modello offre tante soluzioni diverse, mostrando una grande incertezza. Questo è particolarmente utile perché ci permette di identificare i casi “senza speranza” e dire: meglio per ora non considerare una stima poco affidabile, e aspettare osservazioni più profonde per migliorare la qualità dei dati».

Però esistono già modelli che associano ai parametri richiesti anche un’incertezza. In che modo possiamo dire che il vostro lavoro sia ancora più innovativo?

«È vero, per esempio il lavoro di Nils Candebat, Germano Sacco e altri colleghi dell’Inaf di Arcetri associa l’incertezza a un modello di machine learning, ma lo fa in modo diverso. Il loro approccio utilizza reti neurali invertibili, che permettono di fare un’inferenza simile a quella bayesiana in modo naturale, ed è particolarmente efficace per certi tipi di predizioni. Il nostro metodo, invece, è più specializzato nella stima del redshift, che richiede una precisione estrema e spesso può presentare più di una soluzione possibile. Da qualche mese stiamo collaborando tutti insieme – io, Germano Sacco, Francesco Belfiore e i nostri collaboratori più giovani – su progetti che vanno proprio in questa direzione. Grazie a diverse pubblicazioni recenti e ai progetti in corso, l’Osservatorio di Arcetri sta diventando un nodo importante nello sviluppo di metodi di machine learning per l’astrofisica capaci di gestire bene le incertezze nelle predizioni, un aspetto cruciale per il nostro campo».

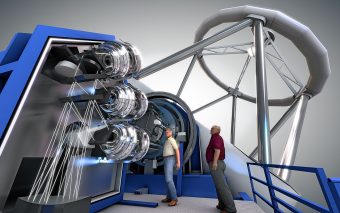

Lo spettrografo ottico e infrarosso Moons, destinato al Very Large Telescope dell’Eso, in Cile (illustrazione artistica). Crediti: Eso

Perché avete scelto proprio Moons per testare questo strumento?

«Moons è uno strumento rivoluzionario, progettato per raccogliere dati spettroscopici di altissima qualità su un numero enorme di galassie – quasi mezzo milione – coprendo un’ampia gamma di redshift. Grazie alla sua combinazione di sensibilità, alta risoluzione spettrale e capacità di osservare contemporaneamente molti oggetti, Moons sarà fondamentale per studiare l’evoluzione delle galassie in momenti cruciali della storia dell’universo, come l’epoca del “mezzogiorno cosmico”, quando l’universo aveva circa la metà della sua età attuale. La sua copertura spettrale, che si estende fino al vicino infrarosso, consente inoltre di accedere a diagnostiche essenziali per analizzare proprietà come il tasso di formazione stellare, la massa stellare e la metallicità, anche in galassie lontane e deboli. Un aspetto fondamentale è che per Moons disponiamo di dati simulati estremamente realistici, scrupolosamente preparati dai miei colleghi. Questi dati ci permettono di addestrare e testare il nostro modello con precisione, preparandoci al meglio per l’arrivo dei dati reali. Il nostro tool può anche supportare la definizione di strategie osservative ottimali, massimizzando l’efficienza del prezioso tempo osservativo che scienziati e scienziate avranno a disposizione con Moons. Ci tengo a sottolineare che questo lavoro è frutto di uno sforzo corale: dalla generazione dei dati per l’addestramento del modello, alla progettazione della rete neurale, fino all’interpretazione dei risultati, ogni fase è stata possibile grazie a un lavoro di squadra».

In che modo ritiene che il machine learning cambierà il lavoro dell’astrofisico o si integrerà con questo?

«Il lavoro dell’astrofisico sta già subendo la stessa trasformazione che coinvolge molte altre discipline scientifiche. Pensiamo al metodo galileiano: esso si basa sull’interconnessione tra osservazione, ipotesi ed esperimento. Tradizionalmente, al centro di questo ciclo c’è sempre stato l’essere umano, l’osservatore. Con l’intelligenza artificiale, però, non è più solo il cervello umano a guidare questo processo, ma siamo affiancati anche da “cervelli digitali”.

Questi strumenti possono aiutarci in due modi principali: ottimizzando e velocizzando processi già noti, e rivelando schemi e relazioni nascoste nei dati. Quest’ultimo punto è particolarmente interessante, perché non solo ci permette di gestire meglio la crescente complessità dei dati, ma può anche suggerire nuove ipotesi, aprendo la strada a scoperte inaspettate.

Per saperne di più:

- Leggi su Astronomy & Astrophysics l’articolo “Measuring redshift and galaxy properties via a multi-task neural net with probabilistic outputs: An application to simulated MOONS spectra”, di Michele Ginolfi, Filippo Mannucci, Francesco Belfiore, Alessandro Marconi, Nicholas Boardman, Lucia Pozzetti, Micol Bolzonella, Enrico Di Teodoro, Giovanni Cresci, Vivienne Wild, Myriam Rodrigues, Roberto Maiolino, Michele Cirasuolo ed Ernesto Oliva